欢迎来到ONE PLACE SEO第二期周报,本期主要内容包括,Soft 404错误为什么不好,Bing 站长指南新方针,Rand Fishkin 0点击搜索点击,GSC性能报告数据延迟,fun robots from Gary,提升图片速度的4个技巧……

Gary Illyes 解释为什么 Soft 404 错误非常不好

Soft 404 是指页面返回 200 状态正常,但 Google 认为该页面应该返回 404 页面未找到错误。根据 Gary 的说法,Soft 404 不好,因为它们首先限制了抓取预算,其次是页面不太可能出现在 Google 搜索中;我很喜欢 Gary 本次对于软404错误的类比,当你去一家咖啡店,拿起菜单点了前三个菜,店员都说没有了,你是不是很沮丧或者会直接离店?这就类似Googlebot爬取这些软 404页面的体验,店员其实可以直接在菜单做标识“已售罄”,就类似我们站长直接对这些不可访问的页面处理为 404状态,而不是返回200。

Bing 网站站长指南新增“提示注入(Prompt injection)”

AI已经成为普遍的工具,许多用户也知道,这些AI需要经过反复的“训练”,所以黑客将利用这个漏洞,恶意输入伪装成合法提示,操纵生成式人工智能系统 (GenAI) 泄露敏感数据、传播错误信息或更糟糕的情况。

所以微软在 Bing 站长指南中添加了新的方针,禁止网站使用 Prompt Injection 攻击 LLM。如果站长使用提示注入向网页添加内容,则可能会导致 Bing 将网站从其搜索结果中删除。

Rand Fishkin 2024 年零点击搜索研究

Sparktoro 的 Rand Fishkin 做了一个搜索研究,在美国和欧盟地区,1000次的搜索中,将近60%是没有点击的,具体是US只有374 次点击,EU只有360次,近 60% 的 Google 搜索没有点击就结束,这个调研数据确实很吓人,同时也表明了,SEO流量竞争将会越来越大。另外,桌面端和移动端的搜索点击都出现负面反馈(下降),但是 Google 自有产品(Youtube,Flights,News, Reviews)的点击也在上升(自引流量),这也会导致更多的不公行为从而触发反垄断审查,另一个是不能仅限于传统搜索,多方位拓展流量才可以分到甜食。

更多报告数据可以阅读原文章,2024 Zero-Click Search Study: For every 1,000 EU Google Searches, only 374 clicks go to the Open Web. In the US, it’s 360.

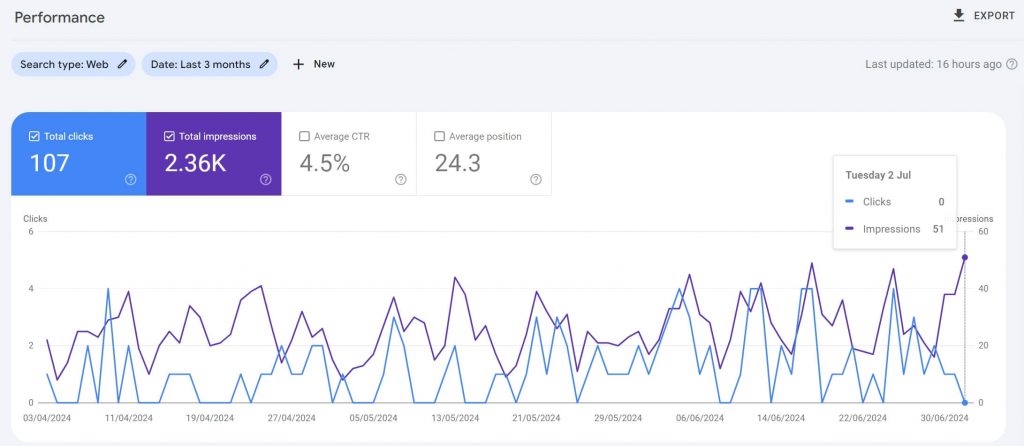

GSC性能报告数据延迟

许多站长都很焦虑,本周 GSC 的性能报告明显延迟,从28日开始,最长是超过96小时(7月4日我跟进的时间),在7月4日下午开始修复至28-29小时,Google 也表示“至少需要 2-3 天才能完全跟上进度”并重新处理数据。7月5日已看到性能报告整体恢复正常。

The data for this report is still catching up and being reprocessed. In the meantime, you might see a fresh data point with partial data. This is expected with data recoveries, and the partial data will be replaced with final data. Thanks for your patience.

— Google Search Central (@googlesearchc) July 4, 2024

以下是最新的情况:

John: 在GSC中使用“请求索引”不会改变规范化

在Linkedin中有个SEOer问 “在一个 301 重定向的旧 URL 上点击 “请求索引”,这是否有可能加快移除过程?“,John的回答为以下,

If you want to remove it, I’d use the removal tools. If you want to nudge canonicalization one way or the other, I’d work to get more of the other canonicalization elements lined up better. A redirect doesn’t guarantee canonicalization – for example, when a site redirects the root URL to a lower-level page, it often still makes sense to index the root URL.

首先是评估页面是否重要,当页面较低级别时,可以不用花费太多时间精力,如果是较高级别的页面,那么新 URL 可以采用“请求索引”,当然链接指向也有一定帮助,还有一个 SEOer 分享,在站点地图中添加重定向的 URL 可以帮助旧 URL 更快地将它们从索引中删除。

Gary 分享关于 robots.txt 超级搞笑的内容XD

Gary 在Linkedin分享了2个很有趣的 robots.txt案例(来自他和John的网站),表示只要robots.txt规则是可解析的,这些规则就可以正常工作,不管是在行字中间插入许多无效字符或者添加视频图片内容(Google会忽略)。

近期有人研究了Reddit 的 robots 文件,发现他们屏蔽了 Google 爬虫,但是通过工具爬取时发现是使用了另一套,也就是采用 UserAgent 区分呈现,所以,只要是 robots 可以给 Google 正常解析,能够 follow 的里面的规则即可。

Sandeep Mallya:使用 Google Trends 进行全面的关键词调研

很多人使用GT只是来比较关键词在某个时间段特定地区的搜索趋势,或者是几个关键词之间的搜索份额占比,但是很多人还不知道这个工具的更多用法,例如挖掘更多搜索趋势飙升的主题或者关键词拓展,还有竞争对手的分析,可以看下Sandeep的整理,我个人觉得非常全面,会给你们更多使用这个工具的不同思路:

Google: 提高网站图片速度的 4 个技巧

Google Search Central发布了关于优化图片速度的技巧,主要有4个,使用正确的图片格式,对图片进行压缩,使用响应式设计和延迟加载。通过遵循这4个技巧,使网站的图像加载更快,从而改善网站用户体验和 SEO表现,详细内容请观看: